T+T Technika a trh

GPU NVIDIA H100 je nyní k dispozici v AWS cloudu |

| Autor článku: Redakce | |

|

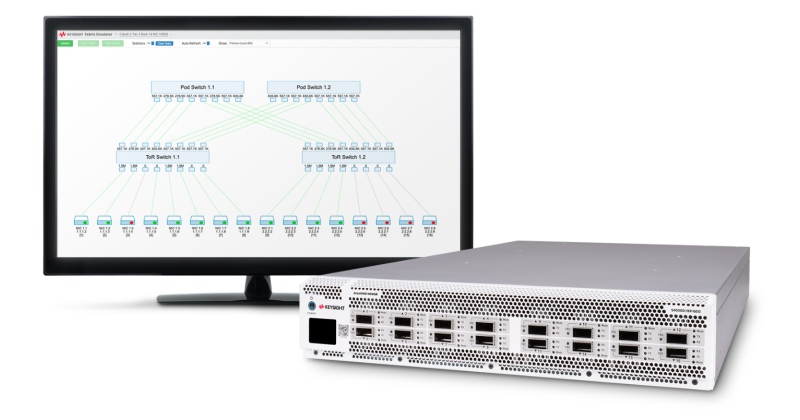

Vývojáři a výzkumní pracovníci používají velké jazykové modely (LLM) k objevování nových aplikací pro AI téměř denně. Uvádění těchto nových případů použití na trh vyžaduje efektivitu zrychlených výpočtů. Grafický procesor Nvidia H100 poskytuje výkon superpočítačové třídy díky inovacím v architektuře včetně Tensor Cores čtvrté generace, nového Transformer Enginu pro akceleraci LLM a nejnovější technologie NVLink, která umožňuje grafickým procesorům komunikovat mezi sebou rychlostí 900 GB/s. Škálování pomocí instancí P5Instance Amazon EC2 P5 jsou ideální pro trénování a provádění inferencí pro stále složitější LLM a modely počítačového vidění. Tyto neuronové sítě pohánějí nejnáročnější a výpočetně nejnáročnější generativní aplikace umělé inteligence, včetně zodpovídání otázek, generování kódů, generování videa a obrázků, rozpoznávání řeči a dalších. Instance P5 lze nasadit v hyperskalárních clusterech zvaných EC2 UltraClusters, které se skládají z vysoce výkonných výpočetních jednotek, sítí a úložišť v cloudu. Každý EC2 UltraCluster je výkonný superpočítač, který zákazníkům umožňuje provozovat nejsložitější trénink AI a distribuované HPC úlohy na více systémech. Aby zákazníci mohli provozovat aplikace vyžadující vysokou úroveň komunikace mezi výpočetními uzly, je instance P5 vybavena neblokujícími sítěmi v petabitovém měřítku, které jsou napájeny pomocí AWS EFA, síťového rozhraní o rychlosti 3200 Gb/s pro instance Amazon EC2. S instancemi P5 mohou aplikace strojového učení využívat knihovnu Nvidia Collective Communications Library a zaměstnávat až 20 tisíc grafických procesorů H100. Nvidia AI Enterprise pomáhá uživatelům co nejlépe využít instance P5 s kompletní sadou softwaru, která zahrnuje více než 100 frameworků, předtrénovaných modelů, pracovních postupů AI a nástrojů pro ladění infrastruktury AI. Nvidia AI Enterprise je navržena tak, aby zefektivnila vývoj a nasazení aplikací AI, a řeší složitost budování a údržby vysoce výkonné, bezpečné a cloudové softwarové platformy AI. Je k dispozici v AWS Marketplace a nabízí nepřetržité monitorování zabezpečení, pravidelné a včasné záplatování běžných zranitelností a rizik, stabilitu API a podnikovou podporu i přístup k odborníkům na Nvidia AI. Další informace o nových instancích AWS P5 s technologií NVIDIA H100.

Mohlo by vás zajímat:

|

Anemometry – co jsou, k čemu jsou určeny a jak jsou konstruovány

Anemometry – co jsou, k čemu jsou určeny a jak jsou konstruovány Skupina Mewa přebírá specialistu na čisté prostory Mikroclean

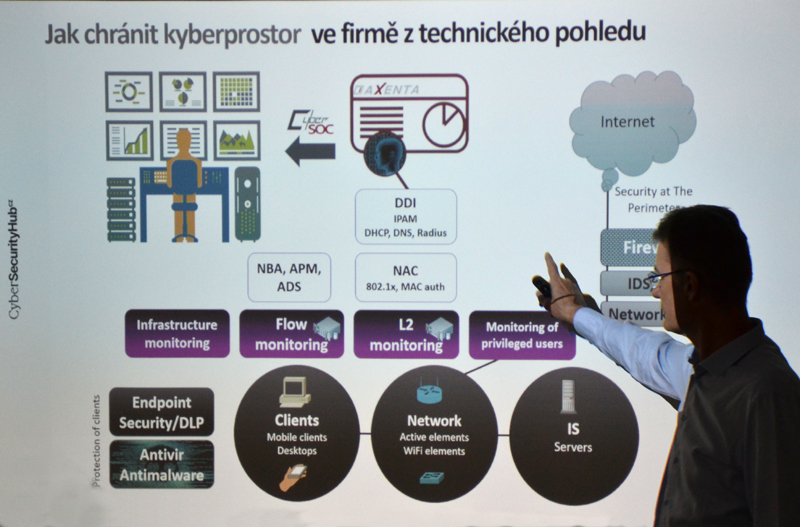

Skupina Mewa přebírá specialistu na čisté prostory Mikroclean Umělá inteligence a kyberbezbečnost

Umělá inteligence a kyberbezbečnost Jak CNC řezací plotr KIMLA našel uplatnění ve výrobě kabinv DFK CAB

Jak CNC řezací plotr KIMLA našel uplatnění ve výrobě kabinv DFK CAB RAVEO nově spolupracuje s Reggiana Riduttori

RAVEO nově spolupracuje s Reggiana Riduttori

Uživatelé

Uživatelé